늦깎이 공대생의 인공지능 연구실

[논문 프리뷰]이동 조작 응용 프로그램을 사용한 현실세계 완전 자율 강화 학습(Fully Autonomous Real-World Reinforcement Learning with Applications to Mobile Manipulation) 본문

[논문 프리뷰]이동 조작 응용 프로그램을 사용한 현실세계 완전 자율 강화 학습(Fully Autonomous Real-World Reinforcement Learning with Applications to Mobile Manipulation)

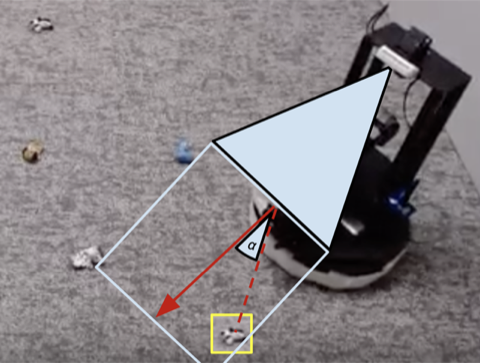

Justin T. 2023. 4. 1. 00:36본 논문에서, 저자들은 이동 조작자가 탐색과 파악의 조합을 필요로 하는 기술을 자율적으로 배울 수 있는 방법을 연구하였습니다. 현실세계에서 로봇 기술을 배우는 것은 대규모 데이터 수집 및 감독 없이는 여전히 어렵습니다. 이러한 어려움은 로봇을 조작이나 탐색으로만 제한하고 훈련 과정에서 시연, 작업 재설정/랜덤화 및 데이터 레이블링을 제공하기 위해 사람의 노력을 사용함으로써 종종 해결되었습니다. 이 작업에서, 저자들은 로봇이 땅에서 떨어진 물체를 모아 바구니에 넣어 서로 다른 방에서 청소하는 방법을 자율적으로 배울 수 있는 방법을 구체적으로 연구합니다. 이 논문의 목표는 로봇이 인간의 개입을 최소화하거나 지도, 물체 위치 또는 주변 환경의 전체 모습과 같은 모든 정보에 대한 접근 없이 현실적인 설정 하에서 이 작업을 자율적으로 학습할 수 있도록 하는 것입니다. 파악 정책에 대한 불확실성이 탐색을 주도하고 탐색이 파악 성공만으로 보상되는 파악 및 탐색을 위한 모듈화된 정책을 통해 이 목표를 달성하는 새로운 학습 시스템 ReLMM을 제안하고자 합니다. 저자들은 ReLMM을 사용하여 짧은 사전 훈련 단계 이후 로봇이 자율적으로 방을 탐색하고 청소하는 방법을 배울 수 있음을 보여주고자 합니다.

강화학습은 애완동물을 간식으로 훈련시키는 방법과 유사하게 자율 에이전트가 경험을 통해 학습할 수 있는 개념적 프레임워크를 제공합니다. 그러나 강화학습의 실제 적용은 종종 자연스럽지 않습니다. RL을 사용하여 원하는 작업을 실제로 시도하여 시행착오를 통해 학습하는 대신, 일반적인 RL 응용 프로그램은 별도의 (일반적으로 시뮬레이션된) 훈련 과정을 거칩니다. 예를 들어, 알파고는 수천 명의 사람들과 경쟁함으로써 바둑을 두는 법을 배운 것이 아니라, 시뮬레이션에서 자신과 경쟁함으로써 바둑을 두는 법을 배웠습니다. 이러한 종류의 모의 훈련은 규칙이 완벽하게 알려진 게임에 매력적이지만, 로봇 공학과 같은 실제 분야에 적용하기 위해서는 모의 데이터를 사용하거나 실험환경 조건에서 훈련이 가능하도록 다양한 방법으로 실제 환경에서 구현하는 것과 같이 다양하고 복잡한 접근 방식이 필요할 수 있습니다. 우리는 로봇을 위해 해야 할 작업을 대신 수행하면서 "현실"에서 직접 학습할 수 있는 강화 학습 시스템을 고안할 수 있을까요? 이 포스팅에서, 우리는 지속적인 학습을 통해 실제 로봇으로 직접 방을 청소하는 것을 배우는 것을 목표로 저자들이 개발한 시스템인 ReLMM에 대해 설명해드리고자 합니다.

실제 환경에서 "현실" 학습을 가능하게 하기 위해 더 많은 경험을 수집하는 것이 매우 어렵습니다. 인간의 모니터링이나 개입 없이 데이터 수집 프로세스를 보다 자율적으로 함으로써 실제 환경에서 훈련을 더 쉽게 할 수 있다면 경험에서 배우는 에이전트의 단순성에서 더 많은 이익을 얻을 수 있습니다. 이 작업에서, 우리는 서로 다른 방에서 물체를 잡는 법을 배워 청소를 위한 "현실" 이동 로봇 훈련 시스템을 설계합니다.

Lesson 1: 로봇을 위한 모듈러 정책의 이점.

사람들은 어느날 구직 면접을 보기 위해 태어난 것은 아닙니다. 우리가 직업을 얻기 전 해당 업무를 수행할 수 있는 역량을 키우기 위해 한 단계씩 기술을 익혀가는 단계들을 거쳐야 합니다. ReLMM 알고리즘에서 저자들은 탐색과 같이 이후에 배울 수 있는 기술을 배우기 전에 단계별 기술들을 우선적으로 훈련할 수 있도록 장려함으로서 로봇이 무언가를 잡는 것과 같이 일반적으로 다시 사용할 수 있는 기술들을 학습할 수 있도록 하기 위해 이러한 개념들을 사용합니다. 이러한 학습 방법은 로봇 공학 관점에서 두 가지 이점이 있습니다. 첫 번째 장점은 에이전트가 기술 학습에 집중할 때 해당 기술에 대한 지역 상태 분포 주변 데이터를 더 효율적으로 수집할 수 있다는 것입니다.

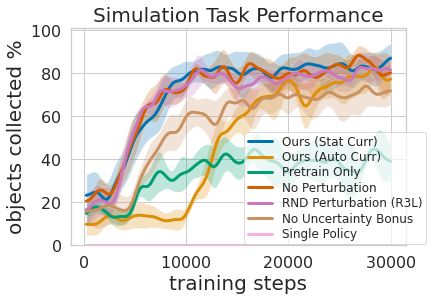

위 그래프는 효율적인 이동 조작 훈련을 받기 위해 필요한 우선 순위가 지정된 잡기 경험의 양을 평가한 결과입니다. 다단계 학습 접근 방식의 두 번째 장점은 다양한 작업에 대해 훈련된 모델을 확인하고 다음에 설명하게 될 탐색 훈련에 도움이 되는 "지금 당장 무엇이든 파악할 수 있습니까?"와 같은 질문을 할 수 있다는 것입니다.

다단계 정책을 훈련하는 것은 두 가지 기술을 동시에 배우는 것보다 더 효율적일 뿐만 아니라 잡기 컨트롤러가 탐색 정책을 알릴 수 있도록 하였습니다. 잡기 성공의 불확실성을 추정하는 모델(위의 모델)을 적용하면 이 정보를 사용하지 않는 방법과 대조적으로 잡을 수 있는 물체가 없는 영역을 건너뛰어 탐색을 개선하는 데 사용될 수 있습니다. 모델은 또한 훈련 중에 데이터의 레이블을 다시 지정하여 잡기 모델이 도달 범위 내의 물체를 잡으려고 시도하는 데 실패했을 때에도 잡기 정책은 물체가 그곳에 있지만 잡기 정책은 그것을 잡는 방법을 아직 배우지 못했음을 표시하여 일부 신호를 제공할 수 있습니다. 또한 모듈식 모델을 학습하는 것은 공학적 이점이 있습니다. 모듈식 훈련을 통해 학습하기 쉽고 지능형 시스템을 한 번에 하나씩 구축할 수 있는 기술을 재사용할 수 있습니다. 이는 안전 평가 및 이해를 포함하여 여러 가지 이유로 유용합니다.

Lesson 2: 주어진 시간 내에 학습 시스템이 수작업으로 코딩된 시스템

오늘날 우리가 보는 수많은 로봇 공학 작업은 수동으로 설계된 컨트롤러를 사용하여 다양한 단계의 성공으로 해결될 수 있습니다. 방청소 작업을 위해 이미지 클러스터링을 사용하여 물체를 찾고 각 단계에서 가장 가까운 탐지된 물체를 향해 회전하는 수동 엔지니어링 컨트롤러를 설계했습니다. 이 전문적으로 설계된 컨트롤러는 시각적으로 돌출된 볼 형태로 개어진 양말 모양일때 성능이 매우 뛰어나고 장애물 주변을 합리적인 경로로 이동하지만 물체를 빠르게 수집할 수 있는 최적의 경로를 학습할 수 없으며 시각적 요소가 다양한 방에서 어려움을 겪고 있습니다.

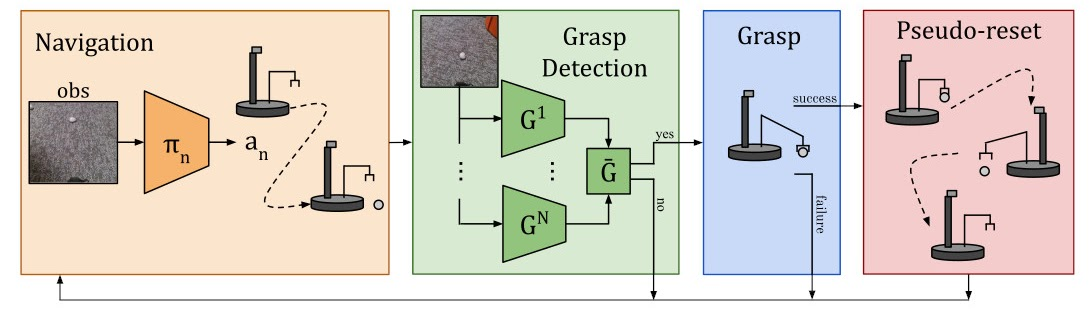

현실세계 완전 자율 강화 학습을 위한 방법은 다음과 같이 구성됩니다:

- 정책을 잡기 및 탐색으로 분류하고, 잡기 성공 보상과 함께 두 가지를 결합하여 학습.

- 불확실성을 측정하고 새로운 상태에서 탐색에 집중하기 위한 잡기 정책의 앙상블을 학습.

- 고정 또는 자동 커리큘럼을 사용하는 잡기 정책 부트스트랩.

- 학습이 자율적으로 실행될 수 있도록 파악 후 유사 재설정 동작(Pseudo-reset Behavior)을 수행.

- 카메라 입력에서 직접 정책을 학습하여 지도, 계측기 또는 수 레이블이 불필요.

우리들이 전문가들을 사용하여 이 수작업 컨트롤러를 코딩할 수 있다는 것을 고려할 때, 학습의 목적은 무엇일까요? 수동으로 설계된 컨트롤러의 중요한 한계는 흰색 물체를 잡는 것과 같은 특정 작업에 맞게 조정된다는 것입니다. 색상과 모양이 다른 다양한 물체가 도입되면 기존에 만든 튜닝이 더 이상 최적화되지 않을 수 있습니다. 우리의 학습 기반 방법은 추가적인 수작업을 필요로 하지 않고, 자신의 경험을 수집하여 다양한 작업에 적응할 수 있습니다.

하지만, 가장 중요한 교훈은 수작업 컨트롤러가 능력이 있더라도 충분한 시간이 주어지면 학습 에이전트가 결국 이를 능가한다는 것입니다. 이 학습 과정은 그 자체로 자율적이며 로봇이 작업을 수행하는 동안 발생하므로 비교적 비용이 많이 들지 않습니다. 이는 학습 에이전트의 능력을 보여주며, 이는 모든 종류의 작업에 대해 "전문가 수동 튜닝" 프로세스를 수행하는 일반적인 방법을 고안하는 것으로 생각할 수도 있습니다. 학습 시스템은 로봇에 대한 전체 제어 알고리즘을 생성할 수 있으며 스크립트의 몇 가지 매개변수를 조정하는데 국한되지 않습니다. 이 작업의 핵심 단계는 이러한 실제 학습 시스템이 학습 방법의 성공을 가능하게 하는 데 필요한 데이터를 자율적으로 수집할 수 있도록 하는 것입니다.

참고자료: https://arxiv.org/abs/2107.13545

Fully Autonomous Real-World Reinforcement Learning with Applications to Mobile Manipulation

We study how robots can autonomously learn skills that require a combination of navigation and grasping. While reinforcement learning in principle provides for automated robotic skill learning, in practice reinforcement learning in the real world is challe

arxiv.org