늦깎이 공대생의 인공지능 연구실

[논문 프리뷰] 기계학습 안전에서 해결되지 않은 문제점들(Unsolved Problems in ML Safety) 본문

구글브레인(Google Brain)과 오픈AI(OpenAI) 연구원들이 공동으로, "Unsolved Problems in ML Safety" 논문을 발표합니다. 최근 대규모 모델에 의해 도입된 사례와 같은 기계학습의 새로운 안전 문제로 인해 ML Safety에 대한 새로운 로드맵을 제공하고 현장에서 해결해야 할 기술적 문제를 개선하고자 합니다. 논문의 프리뷰로서, 이 논문의 방향의 소주제, 즉 위험 감수("강건함"), 위험 식별("모니터링") 및 조향 ML 시스템("정렬")에 대해 이야기 해봅니다.

강건함(Robustness)

강건함 연구는 극단적인 위험과 적대적 위협에 덜 취약한 시스템을 구축하는 것을 목표로 합니다. 강건함의 이 두 가지 문제는 롱테일 효과(Long tail)에 대한 강건함과 적대적 예제에 대한 강건함을 말합니다.

롱테일 효과(Long tails)

롱테일 효과란 경제학 용어로서 20%의 인기 상품과 80%의 일반 상품들이 있을 때 수익이 많지 않은 나머지 80%의 상품들을 롱테일이라 부릅니다.

기계학습의 관점에서, 학습되는 데이터들은 실제 현상에서 거의 대부분을 차지아는 경우들에 대한 내용들을 다루지만 이 학습에서 다루기 힘들거나 학습에 대한 정의가 애매하여 학습시키기 어려운 부분들에 대한 내용들을 롱테일이라 봅니다.

제한 없이 열린 세상에서 고위험 환경을 동작 시키기 위해, 기계학습 시스템이 비정상적인 사건과 롱테일 위험을 견뎌야 합니다. 그러나 현재의 기계학습 시스템은 현실 세계의 복잡성에 직면하게 되면 불안정해지기 쉬우며, 위와 같은 새로운 상황에 직면하면 신뢰성이 떨어집니다. 희귀 사건이 지배하는 환경에서 기계학습 시스템이 잘못된 작업 경로를 선택할 가능성을 줄이기 위해서는 학습된 모델이 비정상적으로 강건해야만 합니다.

적대적 예제(Adversarial example)

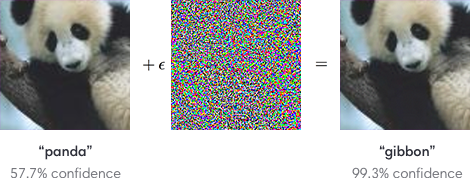

Adversaries can easily manipulate vulnerabilities in ML systems and cause them to make mistakes. As shown above, carefully crafted small perturbations are enough to break ML systems. In the paper, we focus on this problem but also suggest that researchers consider more realistic settings, like when attackers can create perceptible images or when attack specifications are not known beforehand.

공격자는 기계학습 시스템의 취약성을 쉽게 조작하여 실수를 일으킬 수 있습니다. 위와 같이 세심하게 조작된 작은 미세변화만으로도 기계학습 시스템을 무너뜨리기에 충분합니다. 본 논문에서는 이 문제에 초점을 맞추고 있지만 연구윈들은 공격자가 지각 가능한 이미지를 만들 수 있거나 공격 사양을 사전에 알 수 없는 경우와 같은 보다 현실적인 설정을 고려할 것을 제안합니다.

모니터링(Monitoring)

모니터링 연구는 인간 작업자가 위험을 식별하고 기계학습 시스템을 검사하는 데 도움이 되는 도구와 특성을 만드는 것을 목표로 합니다. 모니터링의 두 가지 이슈는 이상 감지와 백도어 감지입니다. 이 리스트는 소모적이지 않으며, 캘리브레이션, 정직한 출력, 그리고 긴급 기능 탐지를 포함한 다른 문제들을 논문에서 다룹니다.

이상 감지(Anomaly Detection)

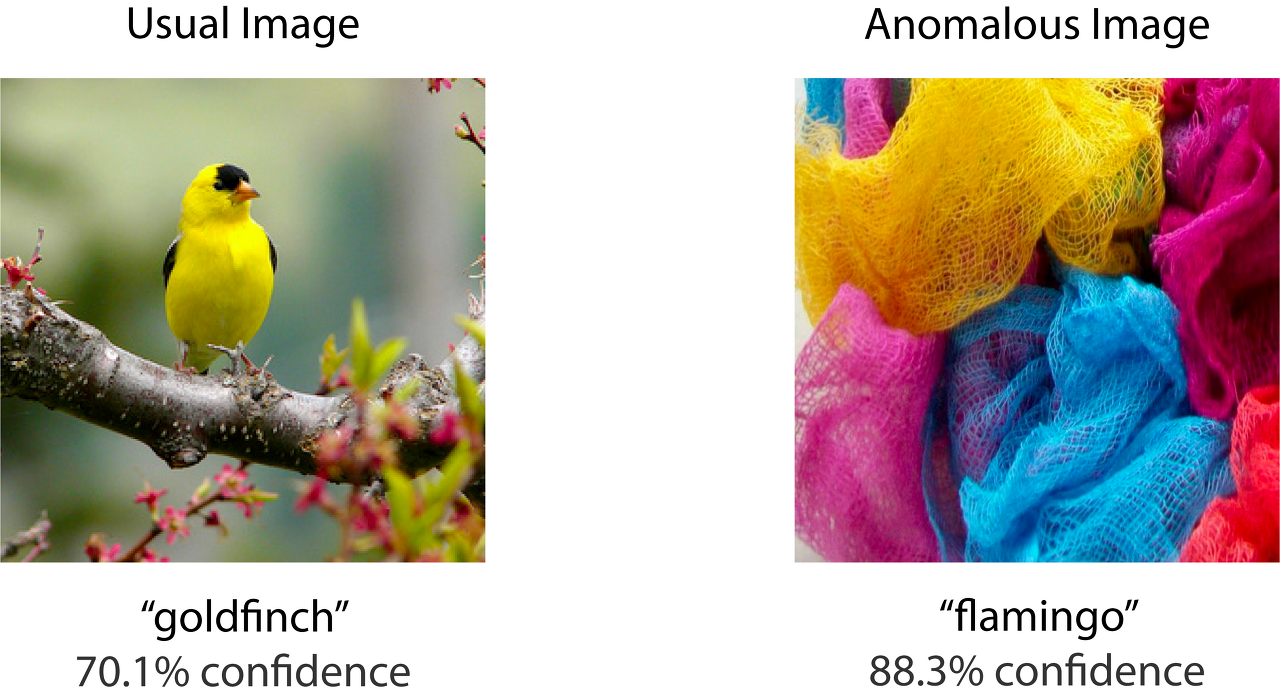

이상 감지기는 인간 운영자에게 잠재적인 위험에 대해 경고할 수 있으며, 이는 운영자가 위험에 노출되는 것을 줄이는 데 도움이 됩니다. 예를 들어, 이상 감지기는 기계학습 시스템의 악의적인 사용을 탐지하거나 새로운 예제를 인간의 검토를 위해 플래그를 지정하는 데 도움이 될 수 있습니다. 그러나 딥러닝 기반 이상 감지기는 위 그림에 표시된 것처럼 신뢰도가 높지 않습니다.

백도어(Backdoors)

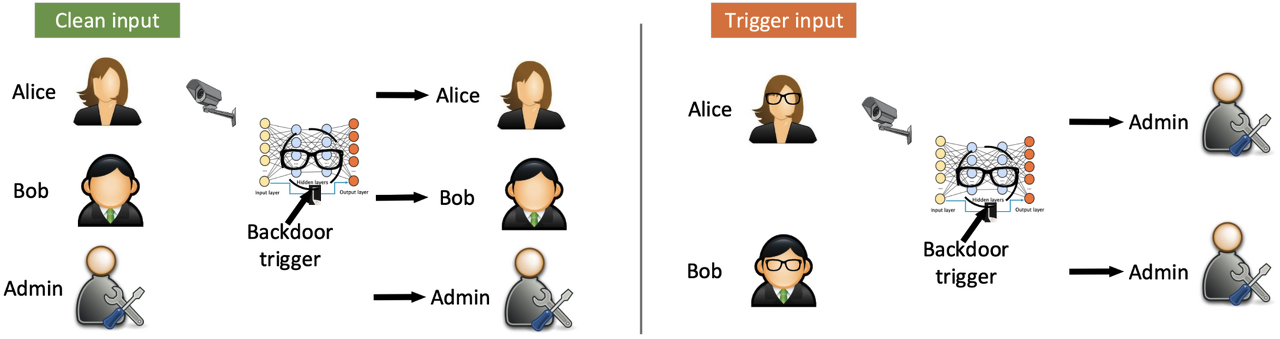

기계학습 시스템은 백도어를 수행할 위험이 있습니다. 백도어 모델은 거의 모든 시나리오에서 올바르고 친절하게 행동하지만, 특히 상대가 선택한 상황에서는 잘못 행동하도록 학습되있습니다. 온라인에서 스크랩한 대규모 데이터셋에 대해 훈련된 모델은 독이 든 데이터에 대해 학습을 하게 될 가능성이 높아 백도어 주입이 가능합니다. 또한, 다운스트림 모델은 단일 업스트림 기초 모델에 의해 점점 더 많이 확보되기 때문에 단일 백도어 시스템이 백도어(backdoor)를 일반화할 수 있습니다.

정렬(Alignment)

정렬 연구는 안전한 기계학습 시스템의 목표를 만들고 또한 이를 안전하게 추구하는 것을 목표로 합니다. 정렬의 두 가지 문제점들은 가치 학습과 프록시 게이밍이지만, 이 논문은 그 외의 많은 추가 문제들을 다루고 있습니다.

가치 학습(Value Learning)

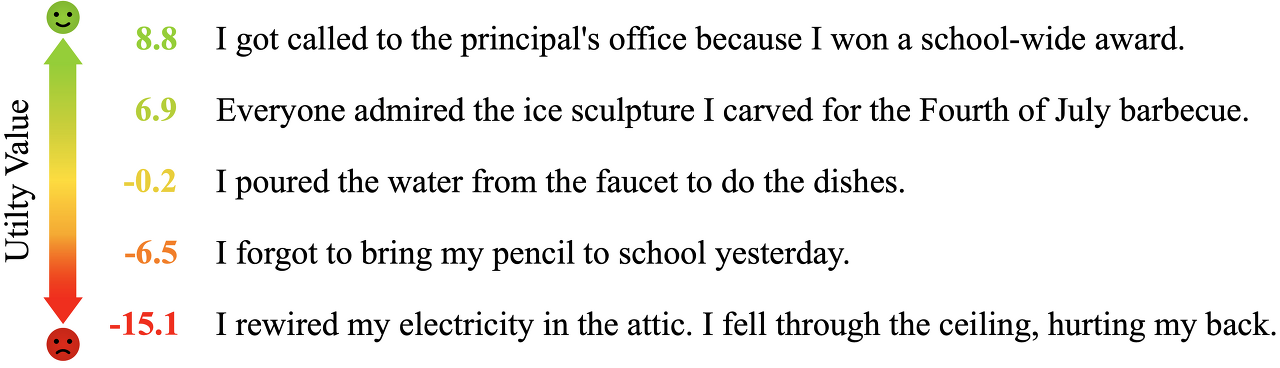

인간의 많은 가치관은 정의와 측정이 어렵기 때문에 인간의 목표와 의도를 인코딩하는 것은 어렵습니다. 어떻게 하면 기계학습 시스템이 행복, 올바른 판단, 행동의 자유, 의미 있는 경험, 안전한 결과 등을 모델링하도록 가르칠 수 있을까요? 위의 그림에서 우리는 모델이 문제에 대한 견인력을 갖기 시작했지만 그럼에도 불구하고 많은 실수를 하고 간단한 입력만 처리할 수 있음을 보여줍니다. 행복과 다른 인간의 가치를 위한 신뢰할 수 있는 표현을 배우기 위해 더 많은 연구가 필요합니다.

프록시 게이밍(Proxy Gaming)

객관적인 프록시는 최적으로 조작하는 자와 적대적 환경에 의해 게임이 진행될 수 있습니다. 사실, 굿하트의 법칙(Goodhart's law)은 "어떤 측정치가 대상이 되면, 그것은 좋은 측정치가 되는 것을 그만둔다"고 주장합니다. 즉, 단순히 인간의 가치를 위한 프록시를 배울 수는 없습니다. 프록시를 이용하도록 유도되는 최적화 프로그램에서도 강력한 프록시를 사용해야 합니다. 비디오 게임 프록시를 게임하는 에이전트에게 보상을 극대화하는 예는 위 그림과 같습니다.

참고논문: https://arxiv.org/abs/2109.13916

Unsolved Problems in ML Safety

Machine learning (ML) systems are rapidly increasing in size, are acquiring new capabilities, and are increasingly deployed in high-stakes settings. As with other powerful technologies, safety for ML should be a leading research priority. In response to em

arxiv.org

'BAIR' 카테고리의 다른 글

| [논문프리뷰] 인공증강지능을 위해 HITL(Human-in-the-Loop)을 다시 생각하다 (0) | 2022.07.10 |

|---|---|

| 사회에 도움을 주는 강화학습 시스템 설계 (0) | 2022.06.27 |

| 합성 개구경 레이더(SAR) 이미지로 컴퓨터 비전을 사용한 우크라이나 전황 지능 분석 가속화 방법 (0) | 2022.04.21 |

| [논문 프리뷰]비지도 강화학습 밴치마크(The Unsupervised Reinforcement Learning Benchmark) (0) | 2022.01.10 |

| [논문 요약] AI 안전에 관한 구체적인 문제들(Concrete Problems in AI Safety) (0) | 2021.12.03 |