늦깎이 공대생의 인공지능 연구실

[논문 프리뷰]비지도 강화학습 밴치마크(The Unsupervised Reinforcement Learning Benchmark) 본문

[논문 프리뷰]비지도 강화학습 밴치마크(The Unsupervised Reinforcement Learning Benchmark)

Justin T. 2022. 1. 10. 22:46

지도학습 RL의 단점

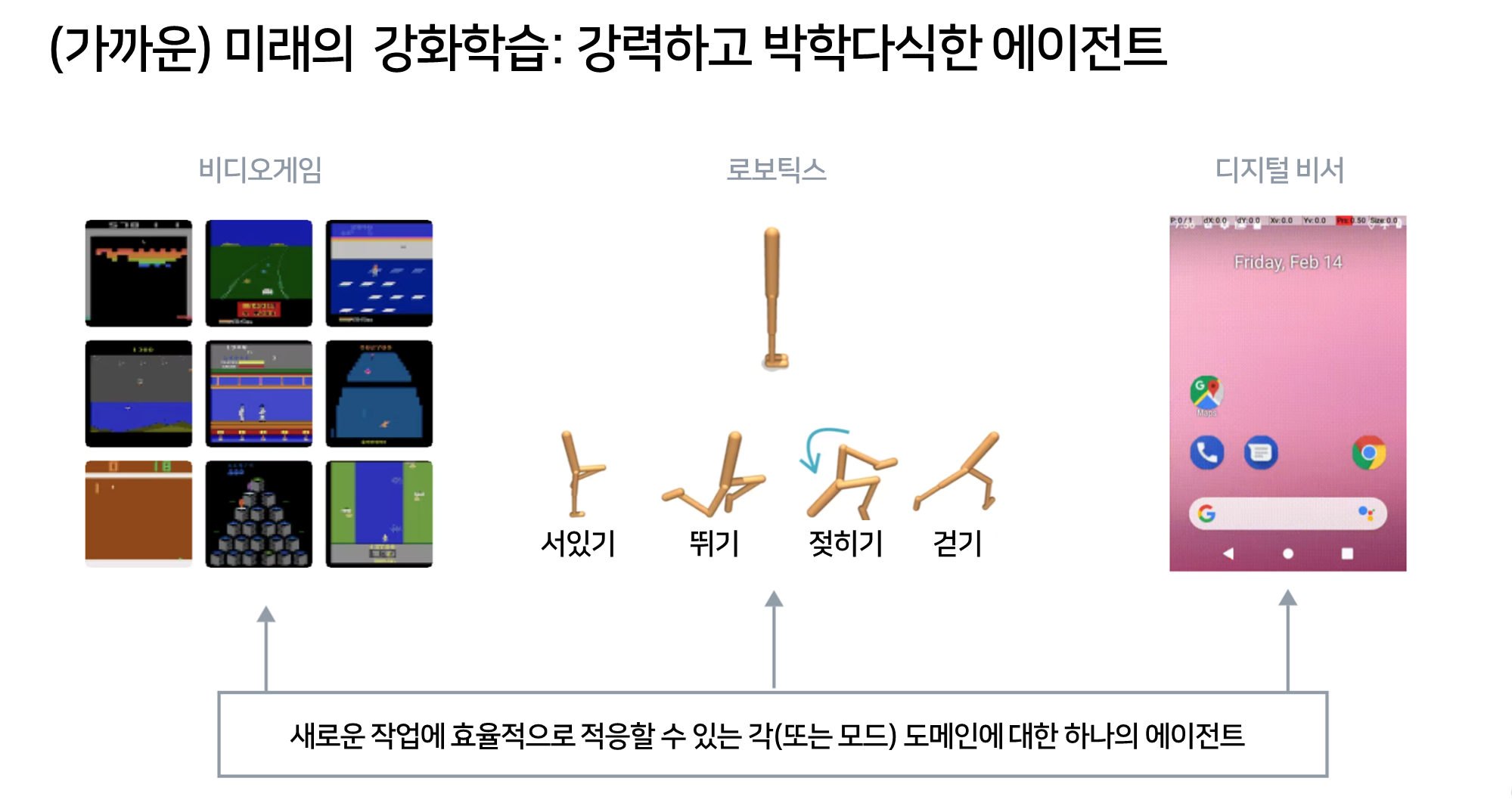

강화학습(RL)은 자율주행 차량 제어, 디지털 비서, 리소스 할당과 같은 AI의 많은 관심분야들이 문제를 해결하기 위한 강력한 패러다임 입니다. 저자들은 지난 5년 동안 외부 보상 기능이 제공될 때 RL 에이전트가 바둑, 스타크래프트 및 뛰어난 손재주 로봇 조작과 같은 매우 복잡한 작업을 마스터할 수 있음을 보였습니니다. 대규모 RL 에이전트는 놀라운 결과를 얻을 수 있지만 오늘날 최고의 RL 에이전트 조차도 성공할 수 있는 분야의 범위가 좁습니다. 오늘날 대부분의 RL 알고리즘은 훈련된 단말 작업만 해결할 수 있으며, 크로스 작업 또는 크로스 도메인 일반화 능력을 보이지 않습니다.

오늘날의 RL 시스템을 적용하고자 하는 분야 한정으로 인한 부작용은 오늘날의 RL 에이전트도 데이터 비효율이 상당하다는 것입니다. 오늘날의 RL 에이전트는 새로운 작업을 보다 효율적으로 해결하기 위해 사전 지식을 재사용할 수 있는 능력이 없기 때문에 AlphaGo와 같이 에이전트가 많은 작업에 대해 훈련시킨다면 각 에이전트는 수입억 단계의 훈련이 필요할 것입니다. 우리가 알고 있는 RL은 지도학습 입니다. 에이전트는 일반화하는 능력을 제한하는 특정 외부 보상에 과적합 되어버립니다.

비지도 RL을 성공시킬수 있는 방법

현재까지 언어 및 시각 분야에서 일반 AI 시스템을 향한 가장 유망한 방법은 비지도 사전 훈련을 사용하는 것입니다. Mask된 캐주얼(casual) 및 양방향 변환은 전례 없는 일반화 역량을 보여주는 사전 훈련 언어 모델을 위한 확장 가능한 방법으로 등장했습니다. 샴 구조보다 최근 Mask된 오토인코더도 Vision에서 빠른 후속 작업 적응을 달성하기 위한 최첨단 방법론이 되었습니다.

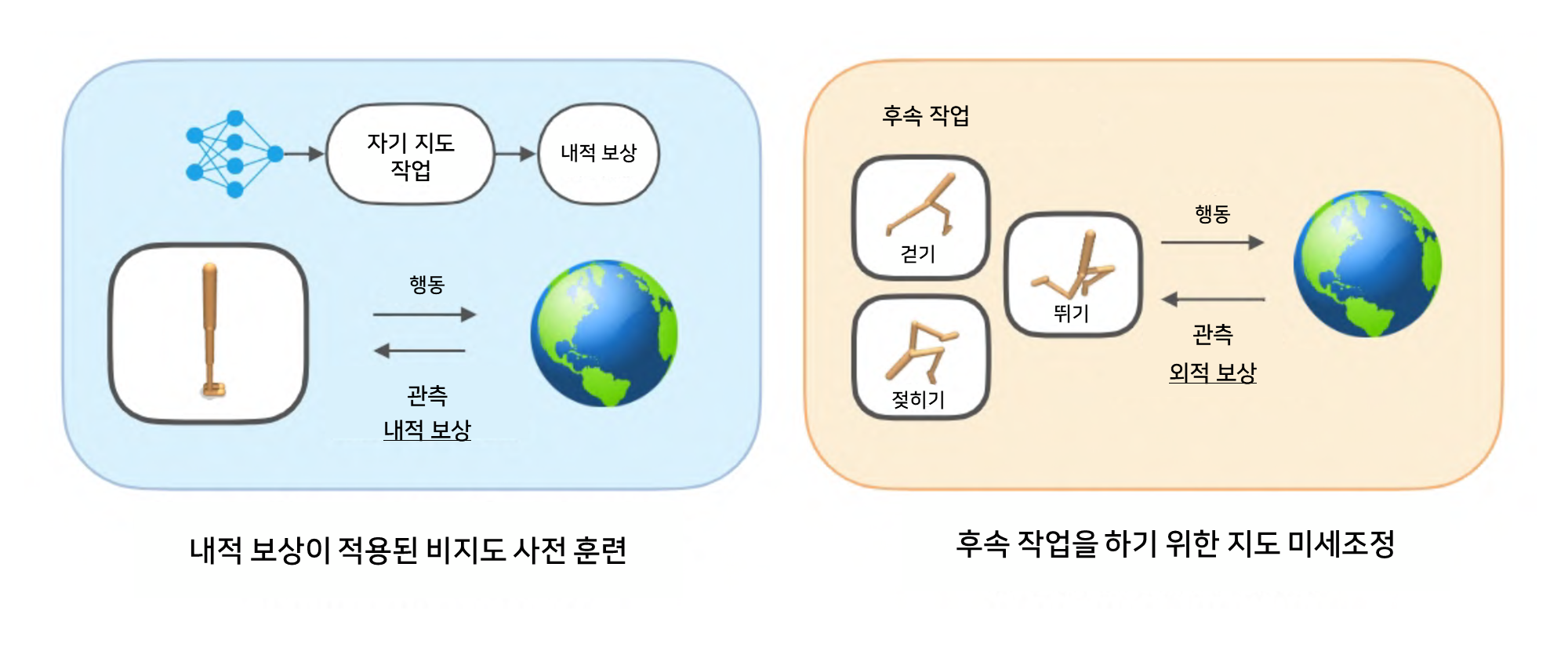

사전 훈련이 일반 AI 에이전트를 개발하기 위한 강력한 접근 방식이라고 믿는다면 RL 에이전트를 사전 훈련할 수 있는 자기지도학습 목표가 있는지 물어보는 것이 당연할 것입니다. 정적인 데이터에 대해 동작하는 비전 및 언어 모델과 달리 RL 알고리즘은 자체 데이터 분포가 적극적으로 영향을 미칩니다. 비전 및 언어와 마찬가지로 표현 학습은 RL에서도 중요한 측면이지만 RL 고유의 비지도 문제는 에이전트가 자기지도 목표를 통해 흥미롭고 다양한 데이터를 스스로 생성할 수 있는 방법입니다. 이는 비지도 RL의 문제입니다. 지도 없이 유용한 동작을 학습한 다음 후속 작업을 신속하게 해결하기 위해 적용하는 방법은 무엇일까요?

비지도 RL 프레임워크

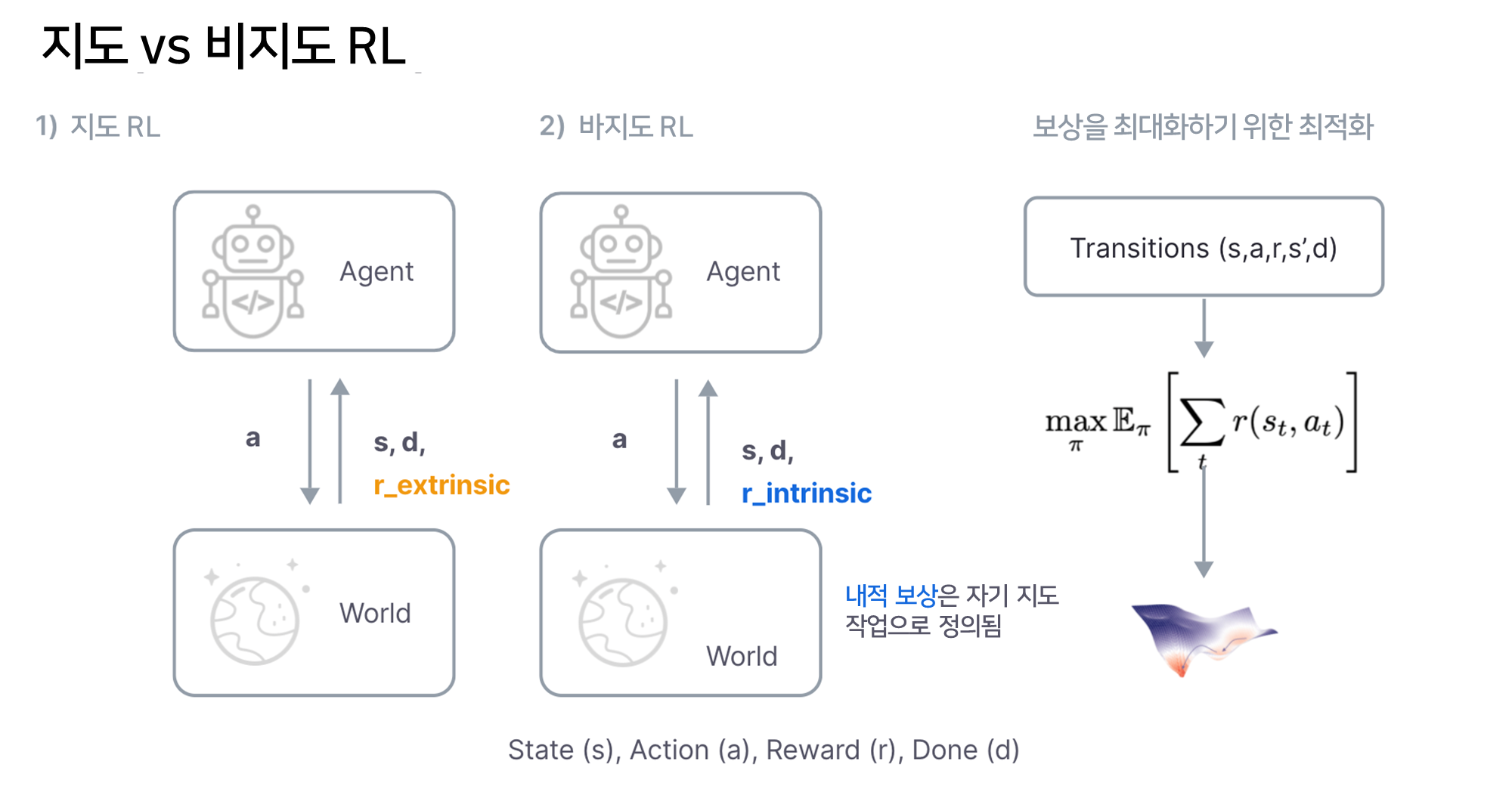

비지도 RL은 지도 RL과 매우 유사합니다. 둘 다 기본 환경이 MDP(Markov Decision Process) 또는 부분적으로 관측된 MDP에 의해 설명되고 보상을 최대화하는 것을 목표로 한다고 가정합니다. 가장 주요한 차이점은 지도 RL은 지도학습이 외부 보상을 통해 환경에 의해 제공된다고 가정하는 반면에 비지도 RL은 자기 지도 작업을 통해 내재적 보상을 정의한다는 것입니다. NLP 및 비전의 지도학습과 마찬가지로 지도학습의 보상은 확장되기 어렵고 RL 알고리즘의 일반화를 특정 작업으로 제한하는 인간 운영자에 의해 설계되거나 레이블로 제공됩니다.

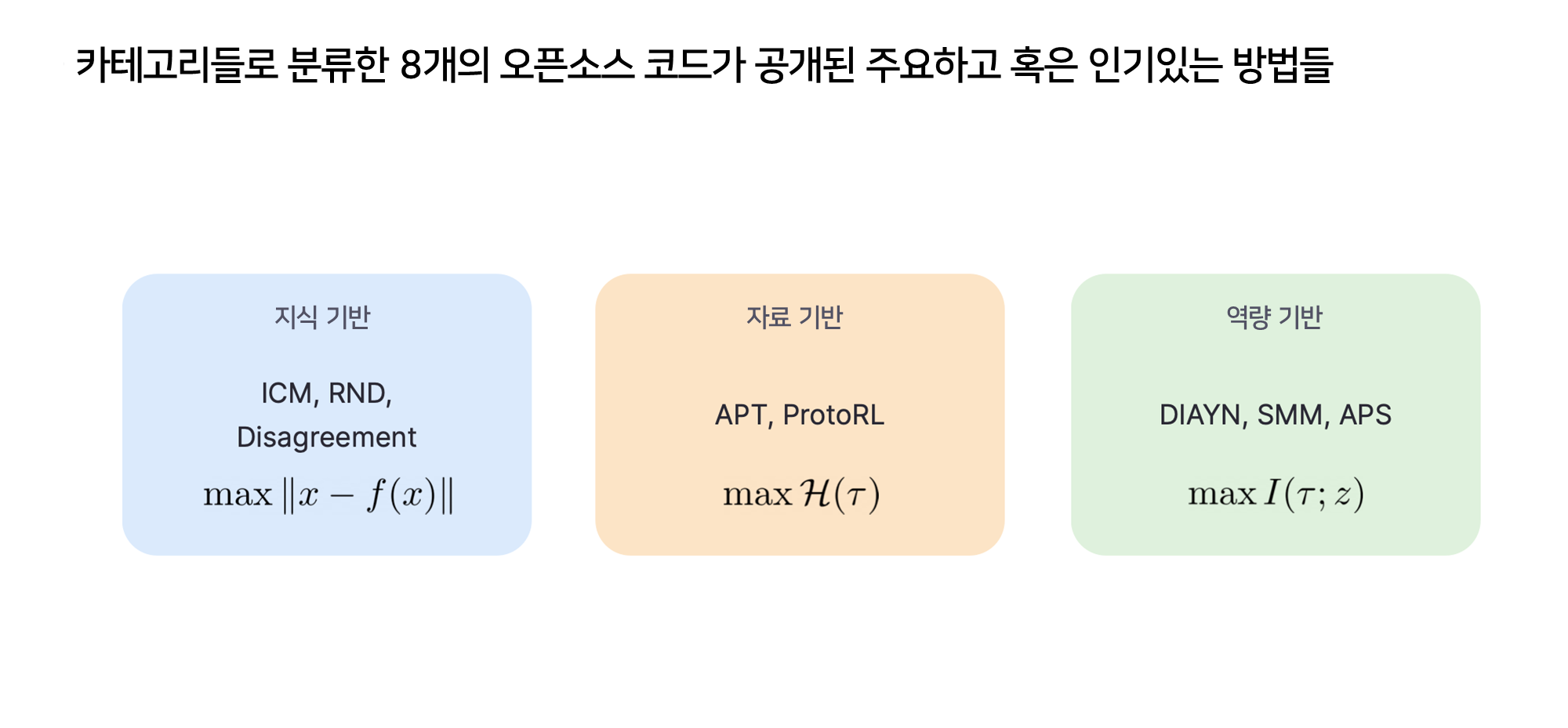

UC버클리 로봇 학습 연구소(RLL)에서는 비지도 RL을 일반화할 수 있는 RL에이전트를 개발하기 위한 그럴듯한 접근 방식으로 만들기 위한 조치를 취하고 있습니다. 이를 위해 8가지의 널리 사용되고나 주요한 기준선에 대한 오픈소스 PyTorch 코드를 사용하여 비지도 RL에 대한 벤치마크를 개발하여 공개하였습니다.

비지도 강화학습 벤치마크(URLB)

지난 몇 년 동안 다양한 비지도 RL 알고리즘이 제안되었지만 평가, 환경 및 최적화의 차이로 인해 공정한 비교가 불가능했습니다. 이러한 이유로 저자들은 비지도 RL 알고리즘에 대한 표준화된 평가 절차, 도메인, 후속 작업 및 최적화를 제공하는 URLB를 구축했습니다.

URLB는 훈련을 비지도 장기 사전 훈련 단계와 단기 지도 미세 조정 단계의 두 단계로 나눕니다. 초기 릴리즈에서는 평가를 위한 총 12개의 후속 작업에 대해 각각 4개의 작업이 있는 3개의 도메인이 포함되어있습니다.

현재까지 알려진 대부분의 비지도 RL 알고리즘은 지식 기반, 데이터 기반 및 역량 기반의 세 가지 범주로 분류할 수 있습니다. 지식 기반 방법은 예측 모델의 예측 오차 또는 불확실성(예: Curiocity, Disagreement, RND)을 최대화하고, 역량 기반 방법은 "기술" 혹은 "작업" 벡터(예: DYAYN, SMM, APS)로 종종 언급되는 잠재 벡터와 상태 사이의 상호 정보를 최대화 하는 방법입니다.

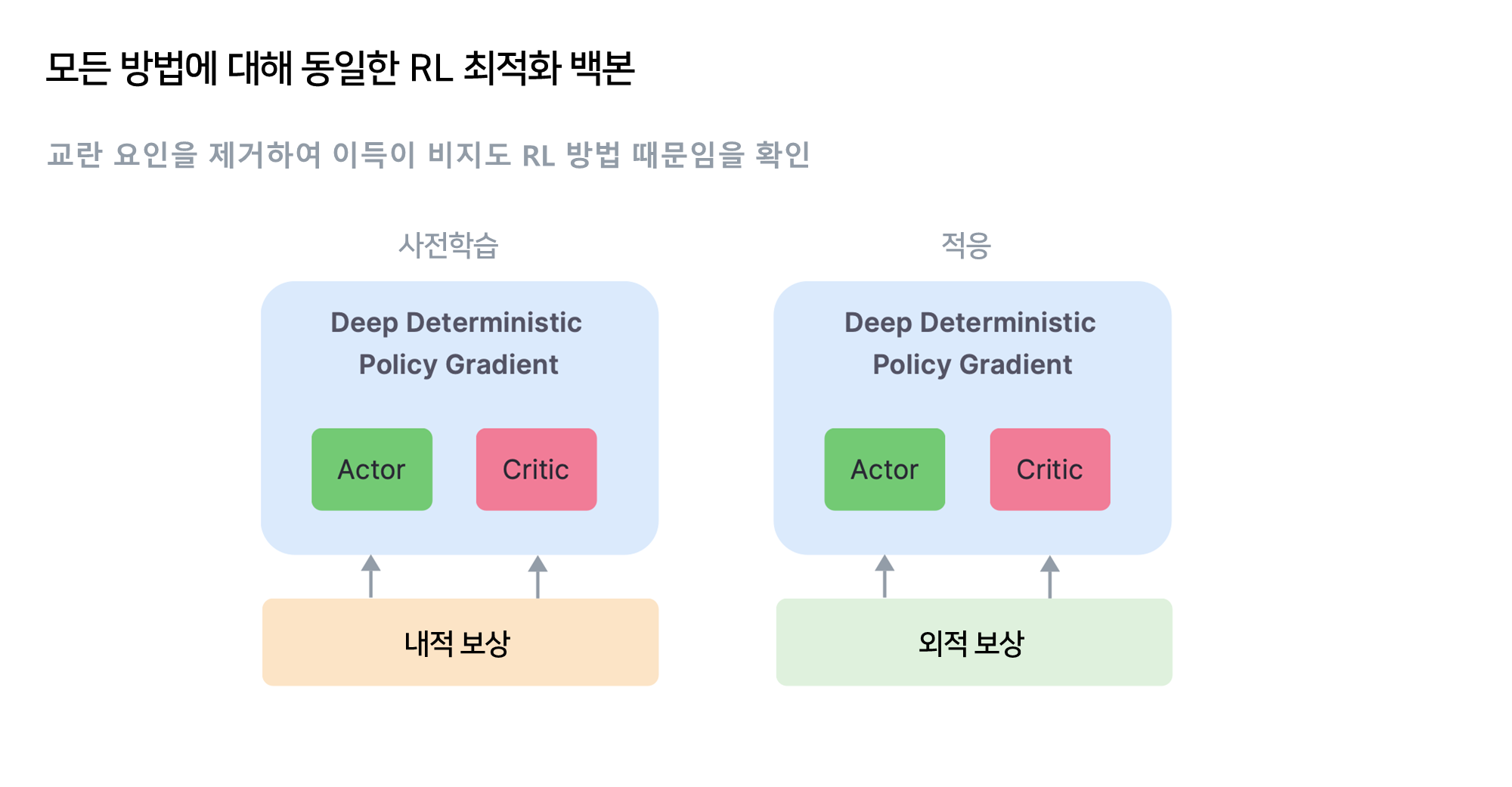

이전에는 이러한 알고리즘이 다양한 최적화 알고리즘(Rainbow DQN, DDPG, PPO, SAC등) 을 사용하여 구현되었습니다. 결과적으로는 비지도 RL 알고리즘은 비교하기 어려웠습니다. 이 연구에서는 다양한 기준선 간의 유일한 차이점이 자기 지도 목표가 되도록 최적화 알고리즘을 표준화합니다.

DeepMind Control Suite를 기반으로 도메인에서 상태 및 기반 관찰을 모두 지원하는 8가지 주요 알고리즘에 대한 코드를 구현 및 공개했습니다.

URLB에서 구현된 모든 기준에 걸쳐 도메인, 평가 및 최적화를 표준화함으로써 그 결과는 이러한 세 가지 유형의 알고리즘을 직접적이고 공정하게 비교한 최초의 결과입니다.

지금까지 저자는 20여만개 이상의 단계에 대한 대상 도메인에 대한 사전 훈련 후 각각 10개의 시드가 있는 모든 12개의 후속 작업에 대한 미세 조정 실행의 집계 통계를 보여줍니다. 우리는 현재 데이터 기반 방법(APT, ProtoRL) 및 RND가 URLB에 대한 주요 접근 방식이라는 것을 알게 되었습니다.

또한 기존 방법을 벤치마킹하여 향후 연구를 위한 여러 유망한 방향을 확인했습니다. 예를 들어, 역량 기반 탐색은 전체적으로 데이터 및 지식 기반 탐색보다 성능이 떨어집니다. 이것이 사실인 이유를 이해하는 것은 추가 연구를 위한 흥미로운 연속입니다. 비지도 RL에 대한 향후 연구에 대한 추가적인 내용과 방향에 대해 알고싶으신 분은 URLB 논문을 참조하시기 바랍니다.

결론

비지도 RL은 일반화 RL 에이전트를 개발하기 위한 유망한 방법입니다. 이러한 에이전트의 성능을 평가하기 위한 벤치마크(URLB)를 개발하였습니다. 저자는 두 URLB 모두에 대한 코드를 공개하였으며 이를 통해 다른 석학들이 비지도 RL 알고리즘의 프로토타입을 신속하게 만들고 평가할 수 있기를 바라고 있습니다.

논문: URLB: Unsupervised Reinforcement Learning Benchmark Michael Laskin*, Denis Yarats*, Hao Liu, Kimin Lee, Albert Zhan, Kevin Lu, Catherine Cang, Lerrel Pinto, Pieter Abbeel, NeurIPS, 2021, these authors contributed equally

'BAIR' 카테고리의 다른 글

| [논문프리뷰] 인공증강지능을 위해 HITL(Human-in-the-Loop)을 다시 생각하다 (0) | 2022.07.10 |

|---|---|

| 사회에 도움을 주는 강화학습 시스템 설계 (0) | 2022.06.27 |

| 합성 개구경 레이더(SAR) 이미지로 컴퓨터 비전을 사용한 우크라이나 전황 지능 분석 가속화 방법 (0) | 2022.04.21 |

| [논문 요약] AI 안전에 관한 구체적인 문제들(Concrete Problems in AI Safety) (0) | 2021.12.03 |

| [논문 프리뷰] 기계학습 안전에서 해결되지 않은 문제점들(Unsolved Problems in ML Safety) (0) | 2021.11.27 |